眸视科技SLAM软件技术

- SLAM(同时定位与地图构建)是指移动机器人在没有环境先验信息的情况下,于运动过程中建立环境模型的同时估计自己运动的过程。

- 通过视觉相机、激光雷达、GPS、IMU、编码器等传感器代替感官观测外部环境信息(包括环境几何、外貌以及语义)和自身运动(包括速度、位置、方向),通过算法估计自身在环境中的位置并能够维护一个描述外部世界的模型。

- 融合激光雷达、视觉、IMU、GPS等多种传感器,结合语义信息、动态环境变化信息,使机器人能够在复杂特定环境下可靠稳定运行。

眸视科技SLAM方案支持激光雷达SLAM,也支持视觉SLAM。同时眸视科技支持激光雷达+视觉融合SLAM方案,也就是在SLAM中同时使用激光雷达与摄像头进行定位与导航。

激光雷达与摄像头属于不同传感器类别,他们分别有各自的优缺点:

激光雷达的优点是能提供准确的距离信息,同时因为激光雷达是自身发光,所以激光雷达能够在完全黑夜的环境中工作。激光雷达的缺点是采样点比较稀疏(比如某些单线激光雷达一个scan只有360个测量点),同时由于激光雷达SLAM方法取决于对齐几何点云,在几何退化场景中(例如长直的隧道)可能会导致SLAM失败。

摄像头能提供丰富的环境信息(RGB)并且信息相对比较稠密(比如普通单目摄像头能提供640*480的像素点的图像信息)。摄像头的缺点是对环境照明条件敏感,比如在黑暗的环境中无法工作。同时在没有特色的环境,如阴天,地面积雪,全白色的墙,也会导致基于视觉的SLAM陷入困境。

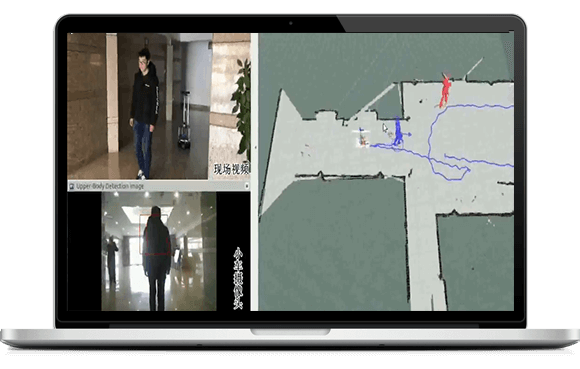

北京眸视科技有限公司作为国内领先的视觉追踪研发单位,实现在未知环境中(未制作地图情况下)追踪目标(人 )行走,实现对指定目标的检测和实时跟踪,做出前进、后 退、左转和右转等基本操作,并且和目标保持1.5米的距离。

智能旅行箱、工厂物品托运、家庭智能监控、特定行人轨迹追踪等。

(1)机器人对行人目标的跟随; (2)机器人保持和追踪目标保持一定范围,在追踪过程中可实现避障; (3)可以实时获取机器人正前方的场景信息,识别行人信息; (4)将机器人行走过程中周围环境制作成地图;

视觉SLAM是利用视觉传感器进行定位导航的算法集合,利用视觉传感器代替激光雷达能够很好的降低SLAM产品的成本,同时精度与激光雷达相近。但是纯视觉SLAM难以在单一重复的场景时有效定位,而传感器+IMU方案能够很好的解决这一难题: 视觉与IMU的融合可以借助IMU较高的采样频率,进而提高系统视觉的输出频率; 视觉与IMU的融合可以提高视觉的鲁棒性,如视觉SLAM因为某些运动或场景出现的错误结果; 视觉与IMU的融合可以有效的消除IMU的积分漂移; 视觉与IMU的融合能够校正IMU的Bias; 单目与IMU的融合可以有效解决单目尺度不可观测的问题。 视觉SLAM系统支持单目、双目、深度摄像头三种类型。

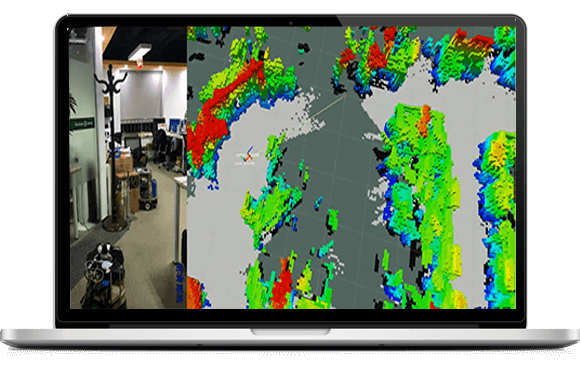

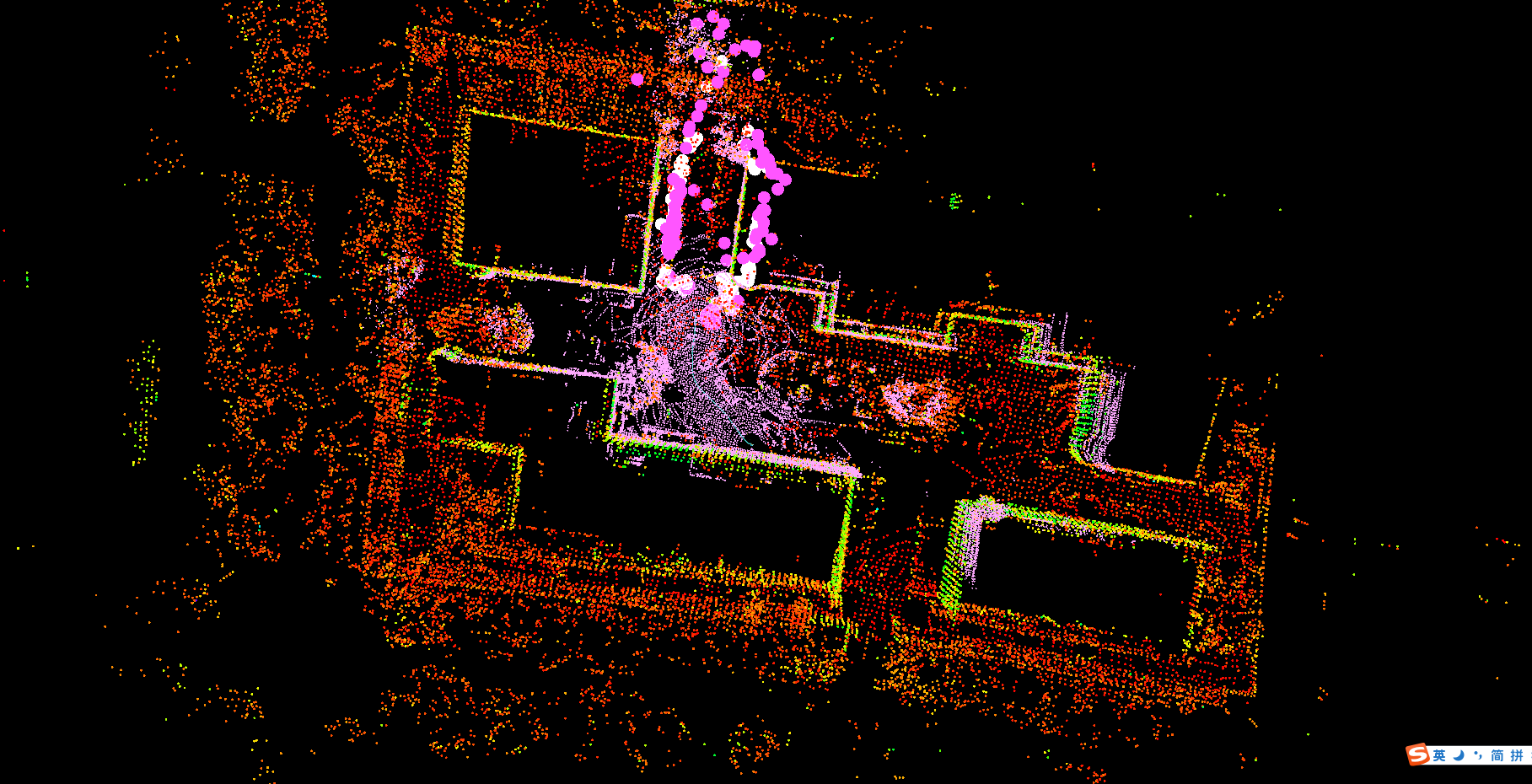

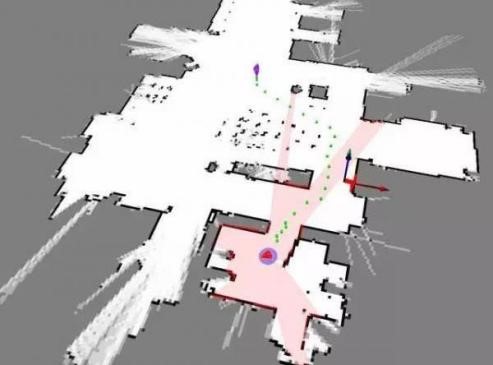

通过平滑和建图实现激光-视觉-惯性里程计的紧耦合框架,用于实时状态估计和建图。

采用因子图的形式,由两个子系统,一个视觉惯性系统和一个激光雷达惯性系统组成;

当两个子系统检测到故障时或者当检测到足够的特性时,可以独立工作;

VIS进行视觉特征跟踪,并可选择使用激光雷达帧提取特征深度信息;

通过优化视觉重投影的误差和IMU测量,视觉里程计可作为激光雷达扫描匹配的初始值,并在因子图中引入约束条件;

在使用IMU测量值进行点云纠正后,LIS提取激光雷达的边缘和平面特征,并将其与在滑动窗口中维护的特征图相匹配;

在LIS中估计的系统状态可以发送到VIS,以方便其初始化;

对于闭环检测,候选匹配首先由VIS识别,并由LIS进一步优化;

在因子图中,联合优化了视觉里程计、激光雷达里程计、IMU预积分和闭环的约束条件。最后,整个系统以IMU的频率输出位姿估计;

通过多传感器融合实现雷达和视觉的能力互补,实现更加鲁棒的SLAM;并且在单一系统失效的情况下仍然能够保证SLAM的正常工作。

基于深度学习技术,卷积神经网络的FASTER-CNN或者YOLO对于行人和物体的快速识别技术,

帮助机器人能够识别周围的目标,并进行跟踪,这可以使得机器人更加智能的感知环境,并进行

相应的控制如避障、更加智能的路径规划等。公司是市场上第一个能够将二维激光雷达和三维

视觉融合并用于机器人定位和导航、行人识别方面的厂家。

融合体现在两个方面:

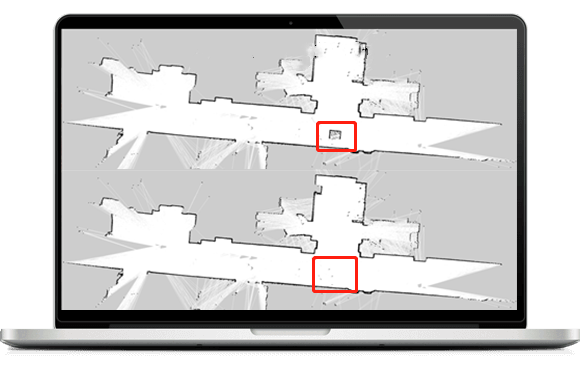

大多SLAM假设周围环境是静态不变的,这是目前SLAM最明显的局限性。因为环境中的物体通常可以分成三类:

通常的SLAM、定位算法都是基于静态环境假设的,也就是假设环境中都是第一类物体,显然,现实环境中并不是这样。动态环境才是更多应用场景的真实情况,所以解决动态环境下的SLAM是业界待解决的一个重要课题。

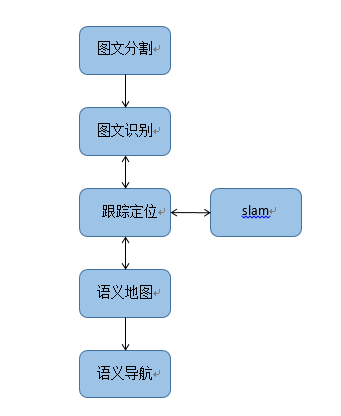

将传统的SLAM方案与深度学习相结合,不仅实现机器人的定位问题,同时,还可以同步识别机器人的周围环境,对环境信息做出语义分割,利用分割后得到的物体进行定位的过程,让机器人从几何和内容两个层次感知世界。目前,我公司已能成功识别出多种目标(文本、行人、电表等,详情见机器视觉部分),并成功将文本信息嵌入了地图中。

机器人前进过程中能使用激光雷达,摄像头,避障雷达等传感设备侦测前进道路上的障碍物,自动避开,实现转向,后退、前左转弯、前右转弯等避障控制功能,能够避免对于行人、设备等的碰撞。

行驶过程中,利用激光雷达不断探测障碍物,并将障碍物信息反馈给路径规划模块。路径规划模块依据已知的地图信息和实时的障碍物信息,规划出绕开障碍物的路径,指令机器人绕开障碍物。

行驶过程中,利用超声波不断探测障碍物,并将障碍物信息反馈给路径规划模块。路径规划模块依据已知的地图信息和实时的障碍物信息,规划出绕开障碍物的路径,指令机器人绕开障碍物。

行驶过程中,利用视觉不断探测障碍物,并计算出障碍物的位姿,然后将障碍物信息反馈给路径规划模块。路径规划模块依据已知的地图信息和实时的障碍物信息,规划出绕开障碍物的路径,指令机器人绕开障碍物。